Очень доволен работой с сервисом Referr. Гибкие тарифы и индивидуальный подход к каждому проекту. Качественные крауд-ссылки с трастовых сайтов и форумов, помогающих усилить ссылочный профиль и разбавить его!

Представляем вам перевод пособия о Web 2.0 для начинающих. А в конце мы добавили список актуальных, трастовых Web 2.0 ресурсов на 2024 год.

Всем известно, что обратные ссылки с сайтов Web 2.0 являются неотъемлемой частью сети блогов или сателлитов (PBN).

Несмотря на то, что обратные ссылки с сайтов Web 2.0 бесплатны, их можно с успехом использовать для продвижения основного сайта.

Поговорим о самом эффективном и, без сомнения, простом способе создания сети блогов Web 2.0.

Создать Web 2.0 блог довольно просто. Сервисы Web 2.0 представляют собой ресурсы, создаваемые на бесплатных поддоменах и содержащие определенное количество качественных постов.

Как же выглядят такие блоги?

Рассмотрим на примере:

Я создал этот Веб 2.0 сайт в 2016 году в рамках одного небольшого проекта. Нужно отметить, что сайт занял неплохую позицию в результатах поиска по нужным мне ключевым словам.

Вскоре я свернул проект, так как занялся переделкой платформы на nodejs. Но на тот момент, когда проект еще существовал, мне удалось продвинуть свой сайт на 3 место в результатах поиска по заданным ключевым словам исключительно благодаря созданию качественного Web 2.0 сайта.

Предугадывая следующий вопрос читателей о том, в чем же заключается секрет создания успешных сервисов Web 2.0, я отвечу так:

«Нет никакого секретного ноу-хау или волшебного приема, которые бы позволили создать успешный Web 2.0 блог. Все дело в правильной структуре!».

«Что значит правильная структура?» — спросите вы.

Отличный вопрос!

Не так давно я часто экспериментировал с Web 2.0 сайтами и выяснил, что в моем случае неплохо работают следующие правила:

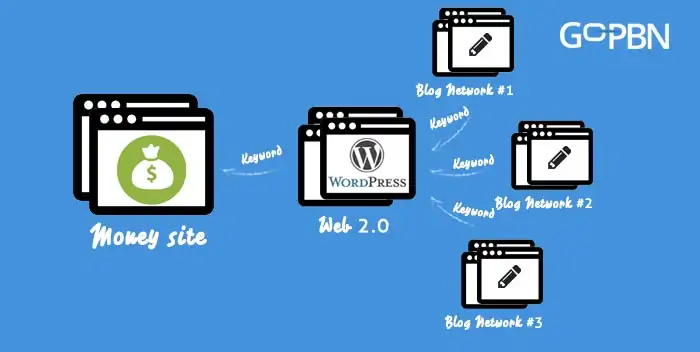

Вы можете использовать сеть сайтов Web 2.0 двумя способами

Что такое «буферный сайт»?

Буферный сайт — это промежуточный сайт между сайтом, который приносит вам доход и сетью блогов.

И так, для чего же нужен такой сайт?

Рекомендую использовать буферный сайт, если стратегия создания ссылок предполагает использование ссылок с других высокоавторитетных сетей сайтов/блогов (которые принадлежат сторонним лицам). С помощью такого сайта вы не только защитите свой коммерческий сайт, но и улучшите статистику вашего Web 2.0 сайта, который будет перенаправлять ссылки с высоким весом к вашему коммерческому сайту.

Наглядный пример:

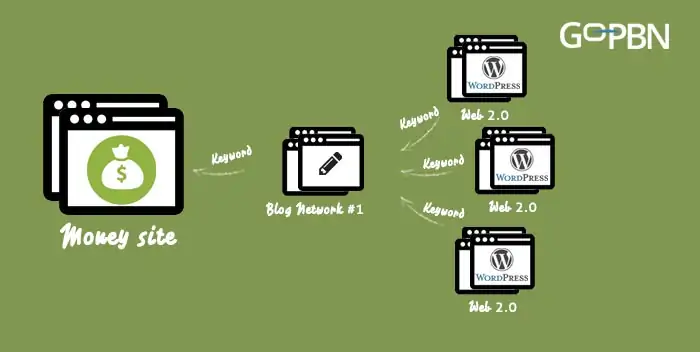

Посмотрите:

Приведенное выше изображение наглядно демонстрирует пример!

Для начала создается несколько блогов Web 2.0, ссылки с которых ведут к ссылкам 1-го уровня.

Если планируете использовать структуру вроде той, что продемонстрирована на рисунке выше, используйте инструмент GSA Search Engine Ranking tool, чтобы перенаправить к вашим сайтам/блогам Web 2.0 как можно больше качественных ссылок.

Можно использовать концепцию Web 2.0 не только для создания сети сайтов, также использовать ее применительно к созданию и раскрутке любого ресурса 1го уровня, например:

Перед тем, как приступить к поиску нужных доменов для создания сети блогов Web 2.0, необходимо будет запастись следующими инструментами:

Я попытаюсь найти несколько качественных адресов Web 2.0 сайтов с истекшей регистрацией в нише, связанной с виртуальным хостингом. Начну пожалуй с ключевых слов.

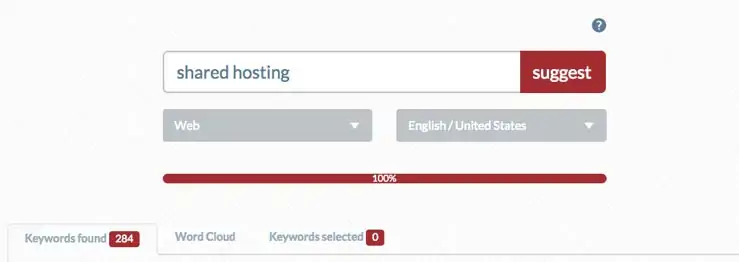

При написании данного пособия я использовал инструмент Ubersuggest. Также можно использовать сервис Keywordtool.io. Однако стоит отметить, что лучше всего для наших целей подойдет версия Pro Plus, которая стоит немало $79/месяц, что может сильно ударить по карману тех, кто хотел бы сократить затраты на продвижение.

Итак, приступим:

Ищем ключевые слова, связанные с виртуальным хостингом. Первоначально я нашел порядка 284 ключевых слова:

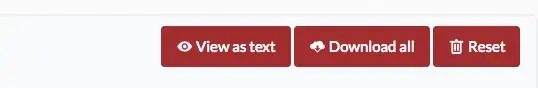

Указанного выше количества ключевых слов будет вполне достаточно для начала. А после того как ключевые слова будут найдены, необходимо кликнуть по кнопке View as text (просмотреть как текст) и скопировать все ключи:

Дальше начинается самое интересное!

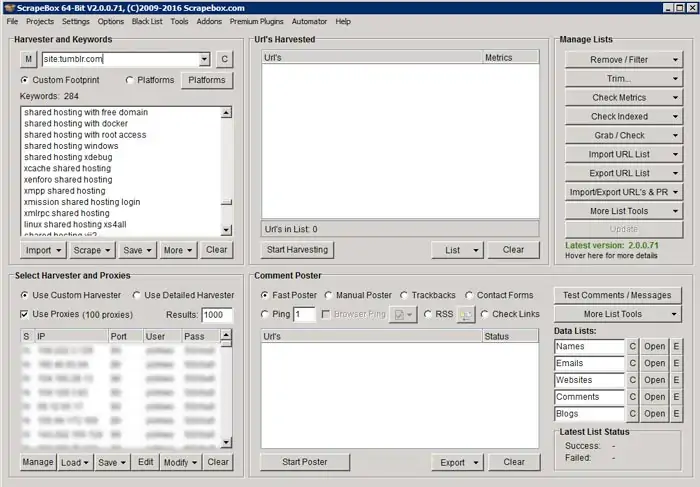

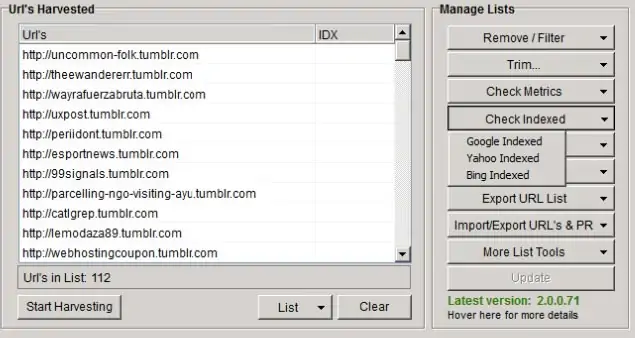

Обратимся к виртуальному серверу Windows VPS и запустим Scrapebox. Загружаем прокси-сервера, вставляем найденные ключевые слова из ubersuggest в поле для ключей в scrapebox:

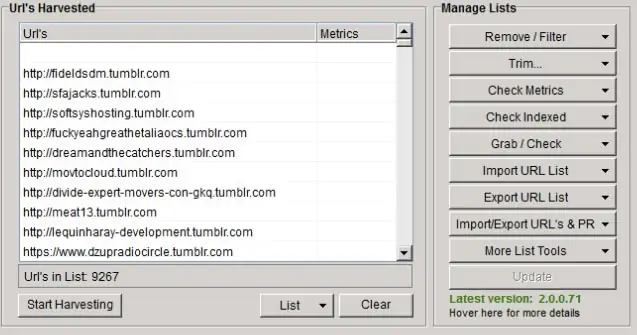

Выполнивши все указанные действия, получите картинку, совпадающую с той, что показана выше, нажмите на кнопку Start Harvesting и вы получите следующий результат:

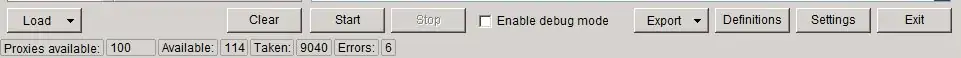

Далее необходимо выбрать поисковики Google, Bing, MyWebSearch и DuckDuckGo, но также можете поэкспериментировать и выбрать другие ресурсы. Кликните по кнопке START. Процесс обработки может занять от нескольких минут до пары часов. Все будет зависеть от качестве интернет-подключения и конфигурации вашего «железа». Чтобы ускорить процесс поиска, рекомендую воспользоваться официальным инструментом Scrapebox Windows VPS моей материнской компании.

Перед тем как продолжить, приведем в порядок адреса и удалим копии:

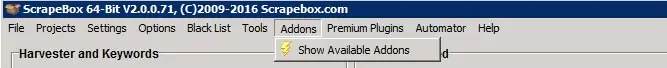

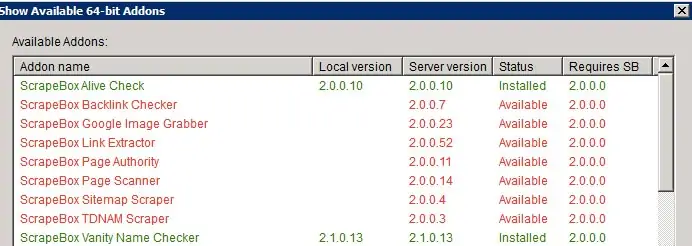

После завершения процедуры кликните по кнопке Addons->Show Available Addons:

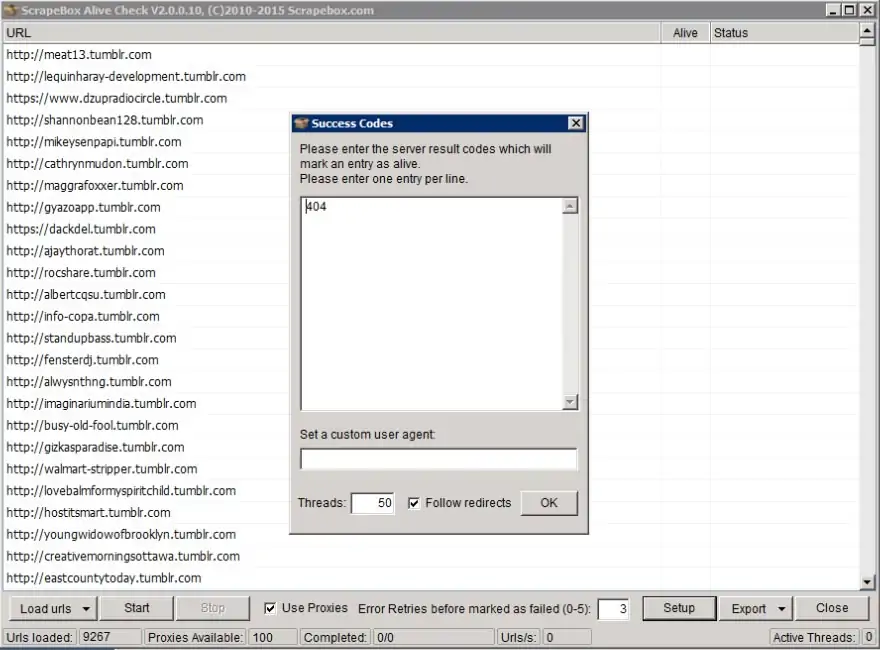

Загрузите расширение Scrapebox Alive Check:

Кликните по кнопке Addons->Scrapebox Alive Check и появится окно, показанное на рисунке выше. Затем кликните также по Load URLs и загрузите все адреса из scrapebox harvester. Далее, кликните по кнопке Setup. В появившемся окне введите код 404, как показано на рисунке выше. Все прочие записи удалите.

Поставьте галочку в поле Use Proxies! Нажмите на кнопку START и ожидайте завершения процесса.

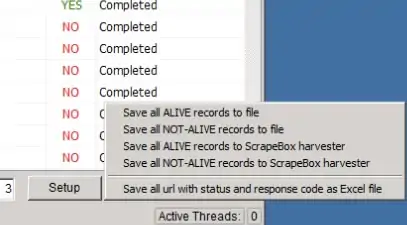

Расширение проверит, существуют ли до сих пор найденные нами адреса. Если адреса не существуют, мы можем поздравить себя с найденной «золотой жилой»:

Выберите действие Save all Alive records to Scrapebox Harvester (сохранить все действующие записи в Scrapebox Harvester).

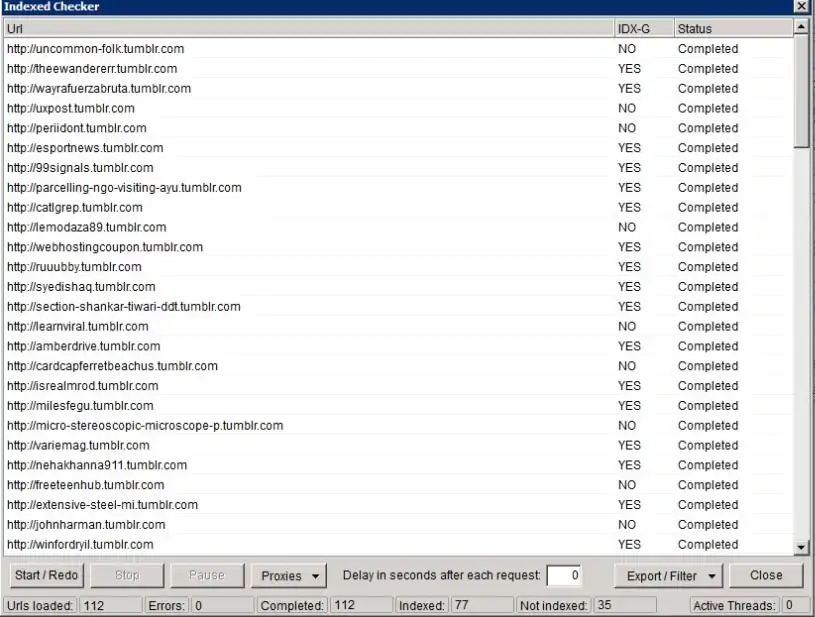

Далее, мы проверим все отобранные нами 112 доменов на предмет их индексирования Google’ом:

Нажмите на кнопку Check Indexed, а затем выберите команду Google Indexed. Вы увидите картинку, похожую на ту, что представлена ниже:

После завершения процедуры экспортируйте список.

Далее, снова зайдите в меню Addons->Show Available Addons и загрузите расширение Scrapebox Vanity Name Checker:

Откройте расширение со вкладки Addons.

Загрузите отобранные URL из Harvester и нажмите на кнопку START!

Подождите и увидите картинку, похожую на ту, что представлена ниже:

Экспортируйте доступный список доменных имен.

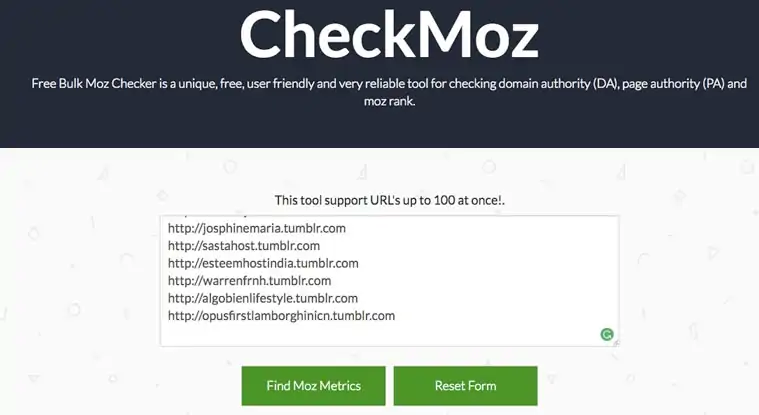

И наконец, давайте проверим такие метрики, как Domain Authority (авторитетность домена) и Page Authority (авторитетность страницы) для найденных нами адресов. В качестве инструмента проверки статистики мы используем CheckMoz.

Скопируйте все найденные с помощью Scrapebox URL и вставьте их в поле CheckMoz:

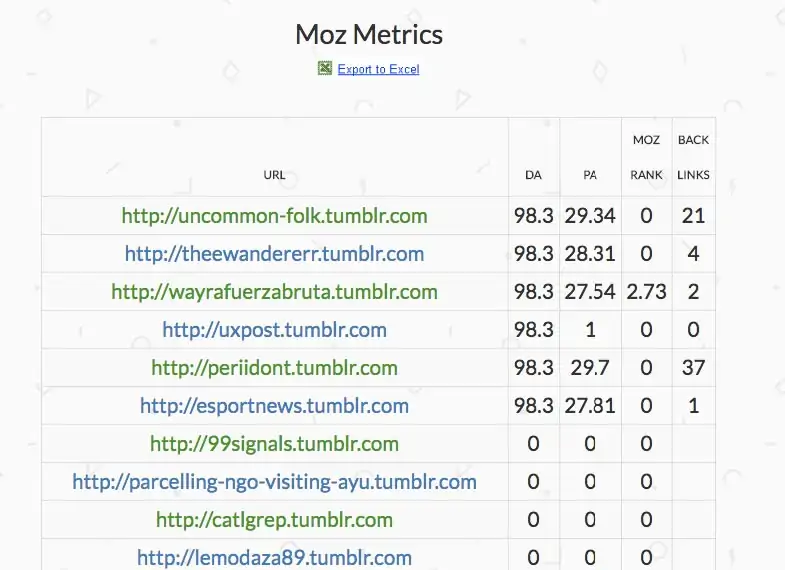

Кликните по кнопке FIND MOZ METRICS! Результат будет иметь следующий вид:

В результате проделанной работы было найдено шесть неплохих адресов сайтов Web 2.0, которые мы сможем восстановить на Tumblr и которые обладают неплохой статистикой. Некоторые из найденных сайтов могут даже содержать обратные ссылки! На момент прочтения данной статьи, возможно, найденные мной адреса больше не будут свободны, поскольку у меня не было намерения регистрировать их.

На всю работу я потратил около 60 минут.

Вы же можете повторить процедуру, используя другие платформы Web 2.0.

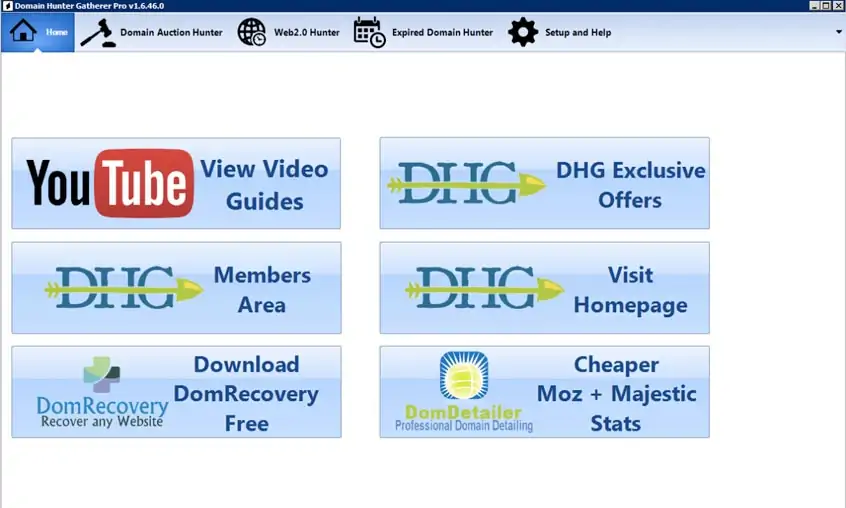

Перед тем как выполнить установку, убедитесь в том, что у вас установлен .net Framework 4.0. После запуска ПО увидите следующую приветственную заставку:

При написании данного руководства я использовал Pro версию программы.

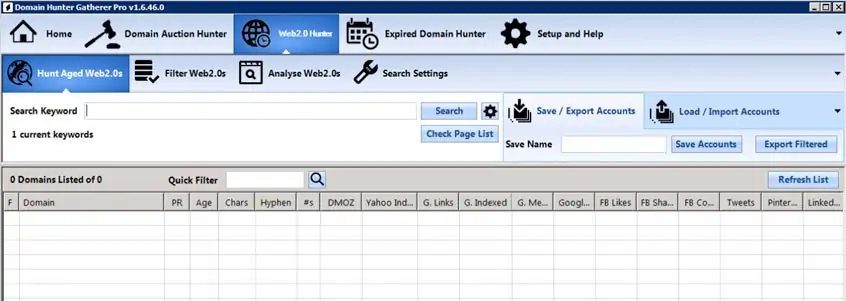

Кликните по вкладке Web 2.0 Hunter. Появится следующее окно:

Перед запуском приложения нужно проверить некоторые настройки. Нажмите вкладку Search Settings:

Вам будут доступны следующие функции:

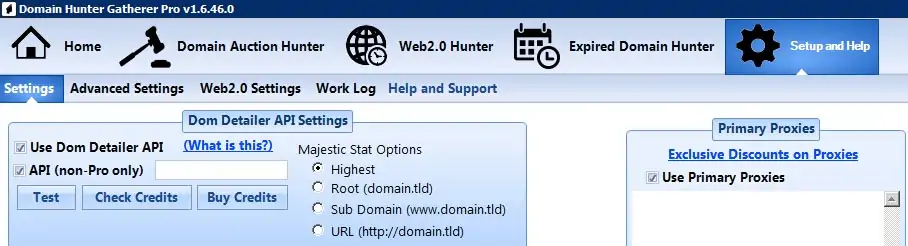

При создании данного руководства я использовал ресурсы Tumblr, WordPress и Blogspot. Я выбрал все варианты поисковых машин и не устанавливал галочку в поле Custom Date Range. Далее, кликните по вкладке Setup and Help на верхней панели:

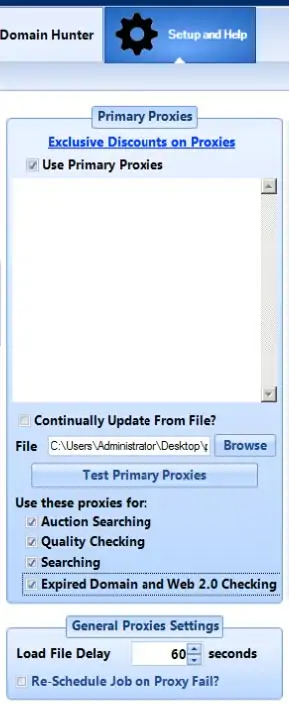

Импортируйте файлы с прокси-серверами и используйте их в качестве основных прокси-серверов. Галочками отметьте поля Auction Searching, Quality Checking, Searching и Expired Domain and Web 2.0 Checking.

А теперь протестируем, как работает Domain Hunter Gather по сравнению с инструментом Scrapebox:

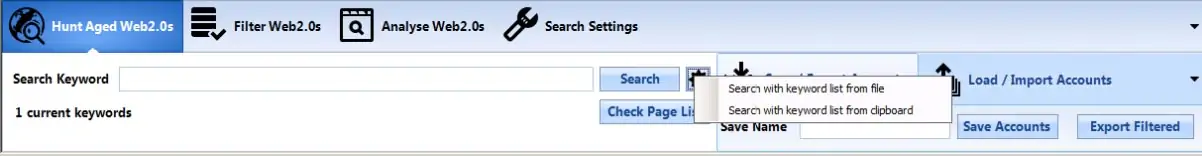

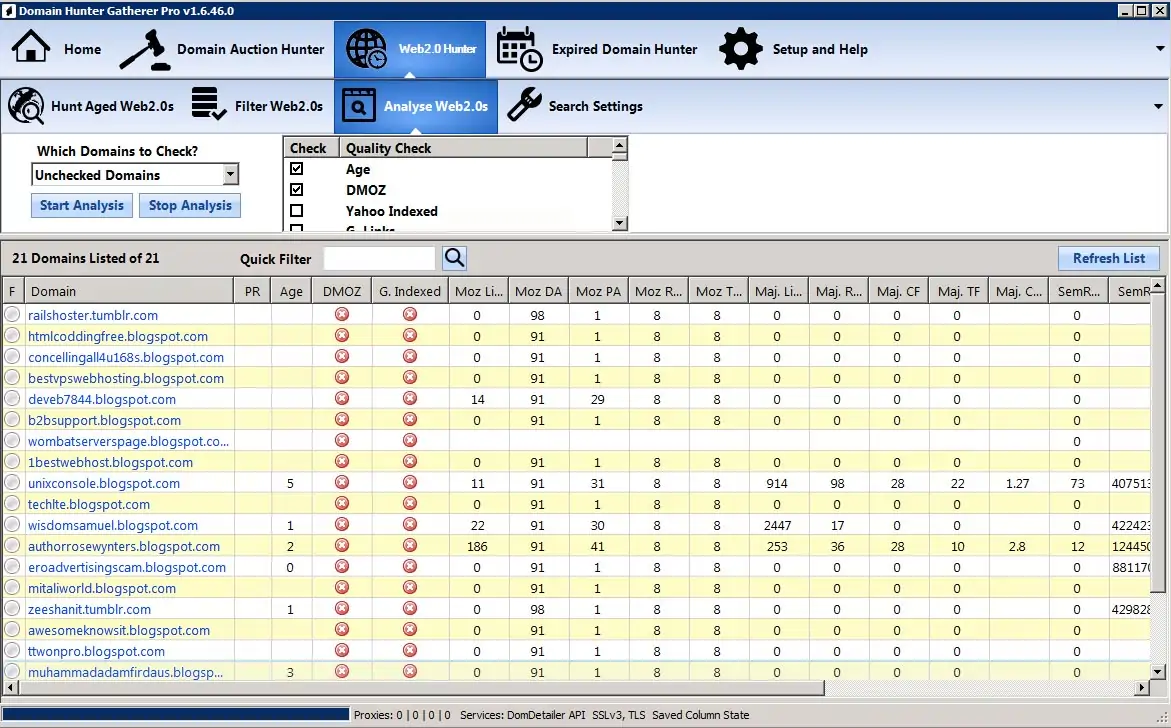

Кликните по вкладке Hunt Aged Web 2.0 и импортируйте ключевые слова из файла или из буфера обмена.

Я скопировал ключи в буфер обмена, поэтому выбрал второй вариант и получил следующий результат:

Если все прошло нормально, жмите на кнопку YES!

А теперь расслабитесь и дайте программе выполнить за вас всю грязную работу.

Процесс поиска может занять 30-60+ минут в зависимости от количества выбранных web 2.0 блогов, качества прокси-серверов и конфигурации сервера. Нужно отметить, что в отличие Scrapebox, Domain Hunter Gatherer требует выполнения гораздо меньшего объема подготовительных работ. Результаты же превзойдут все ваши ожидания!

Если вы планируете создавать большое количество Web 2.0 сайтов и у вас есть лишние 57 долларов/месяц, вы сэкономите много времени, используя данное ПО. Я потратил примерно 30 минут.

Тут все очень просто!

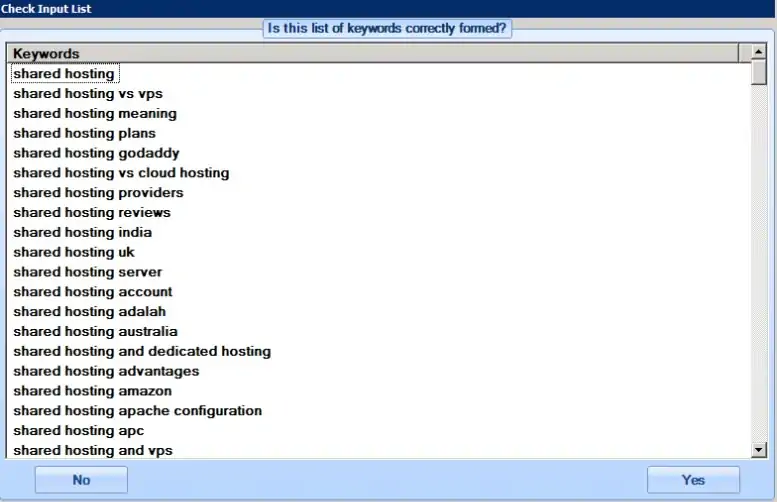

ПО Domain Hunter Gatherer имеет встроенную функцию проверки статистики:

Кликните по вкладке Web 2.0 Hunter, а затем по вкладке Analyse Web 2.0s. Выберите не отмеченные домены и нажмите на кнопку START ANALYSIS! Через несколько минут вы получите статистику.

Вам потребуются так называемые баллы Dom Detailer. Однако при регистрации pro-аккаунта вы по умолчанию получите 50 баллов.

Понимаю, что процесс будет довольно утомительным и трудоемким, но вам обязательно понравится результат.

Итак начнем!

Процесс создания идеального Web 2.0 блога состоит из четырех этапов:

Этап 1 : Выберите первый ресурс Web 2.0 из списка сайтов Web 2.0, упомянутого в конце статьи. После завершения процесса регистрации, переходите к следующему шагу.

Этап 2: У каждого нормального блога должна быть страница «О нас» и «Контакты». Если хотите, чтобы ваш блог выглядел естественно, не забудьте включить в него данные страницы и подключите к нему ваши профили из социальных сетей.

Этап 3: Статьи!

Создайте 10-20 высококачественных статей на заданную тему. Убедитесь в том, что это действительно свежие, уникальные и высококачественные статьи. Неплохой ресурс — Blackhatworld, там можно найти талантливых копирайтеров.

Дважды проверьте уникальность вашего контента, используя инструменты типа Small SEO Tool’s Plagiarism Checker.

Ниже перечислен список того, что должна включать в себя каждая статья. Статья должна:

Этап 4: Планирование!

Создайте график публикации статей на следующие пару месяцев.

Подсказка для профи! Используйте сервис IFTTT для автоматического планирования публикации статей в различных социальных сетях.

А еще вам понадобится:

Итак, вы запустили свой первый Web 2.0 ресурс!

Настало время размещения обратных ссылок на ваш Web 2.0 сайт, который помогут улучшить его статистику. Для размещения обратных ссылок вам потребуются несколько гостевых постов и один блог-пост с хорошей рекламой. Несколько ссылок вы можете купить на Fiverr или BlackHatWorld.

И снова напомню, что процесс создания обратных ссылок должен быть таким же постепенным, как и процесс создания самих ресурсов, чтобы последние выглядели естественно!

Чтобы процесс создания ресурсов был более понятным, мы создали для вас вот такую инфографику:

Проверенный список авторитетных сайтов Web 2.0 на 2024 год:

В дополнение подойдет запись Q/A сессии по продвижению сайтов с помощью PBN с Николаем Кодием:

Хотите заказать линкбилдинг, но не знаете, какого провайдера выбрать? Остановитесь на Реферре.

Referr — первый профессиональный крауд-маркетинг сервис. Наша команда продвигает клиентские проекты крауд-ссылками, SEO-ссылками с сабмитов (локальные каталоги, job-сайты, профили соцсетей), аутричем, гостевыми статьями и Link Insertions. Предоставляем как отдельные тарифы и пакеты, так и услугу «комплексное продвижение сайта ссылками». Работаем на десяти языках в 40+ странах мира.

Читайте наши кейсы по продвижению сайтов и линкбилдинг отзывы, чтобы ознакомиться с нашим подходом.